Visual safety detection method based on improved YOLOv8 personnel detection model

-

摘要:

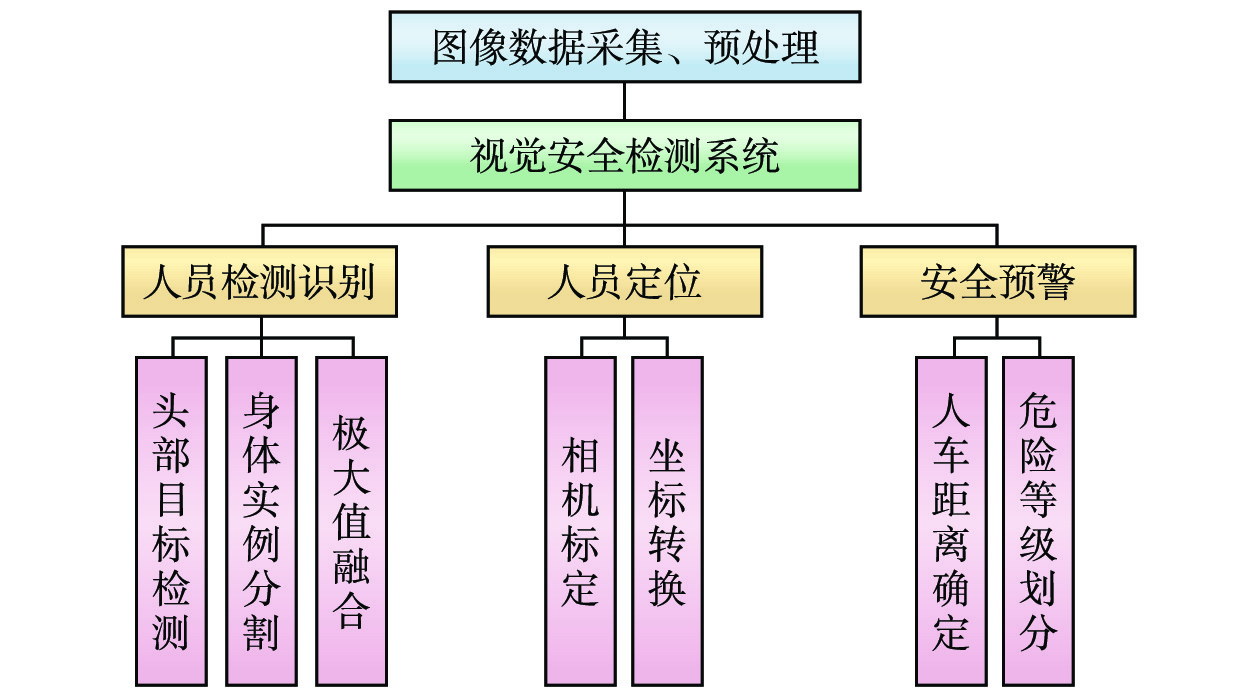

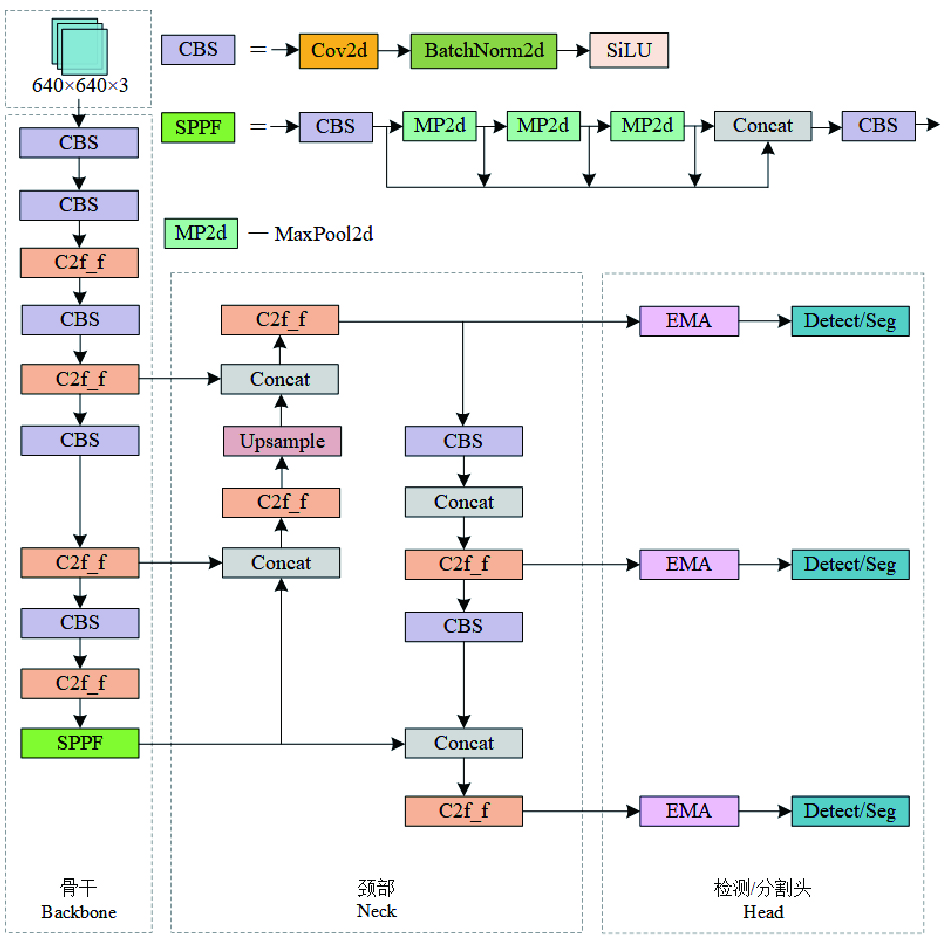

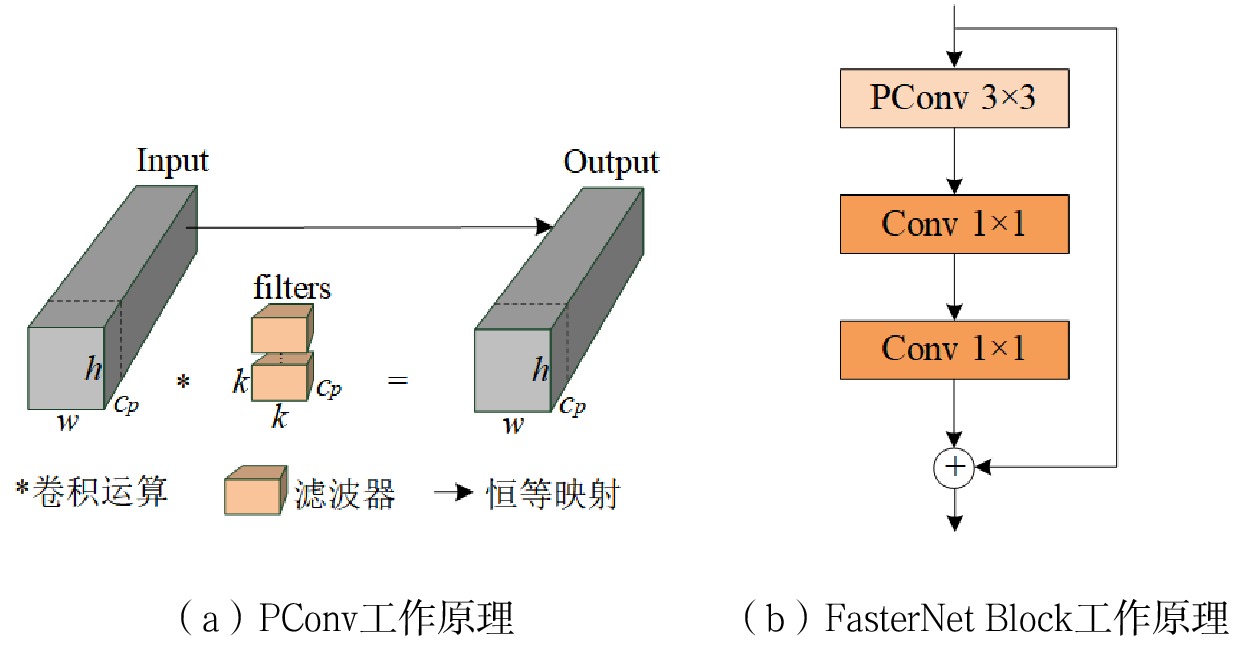

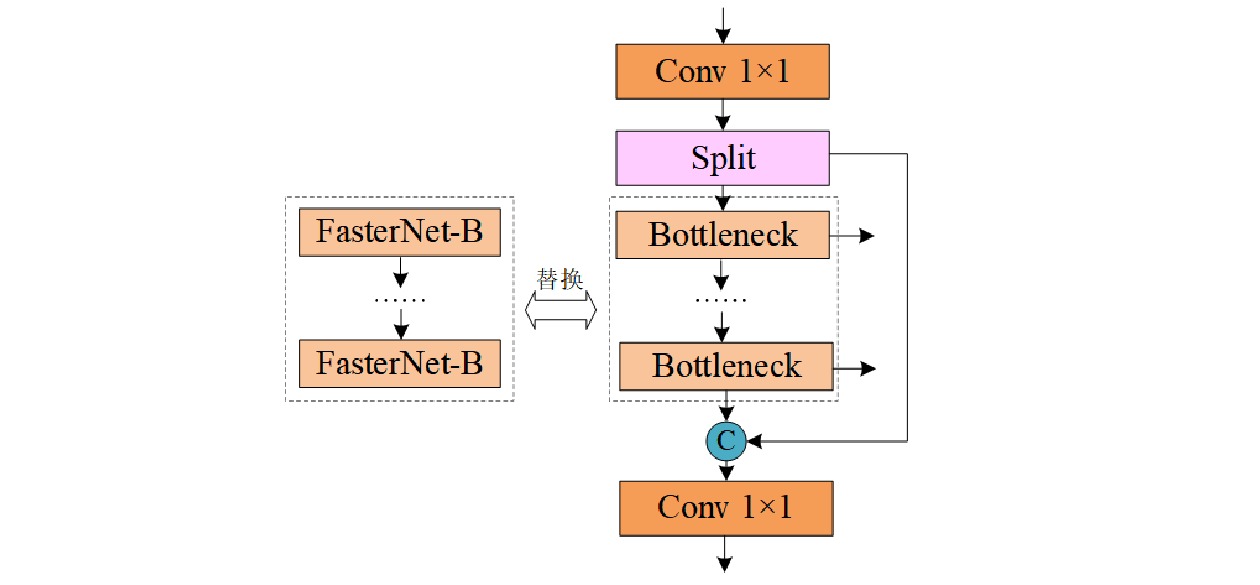

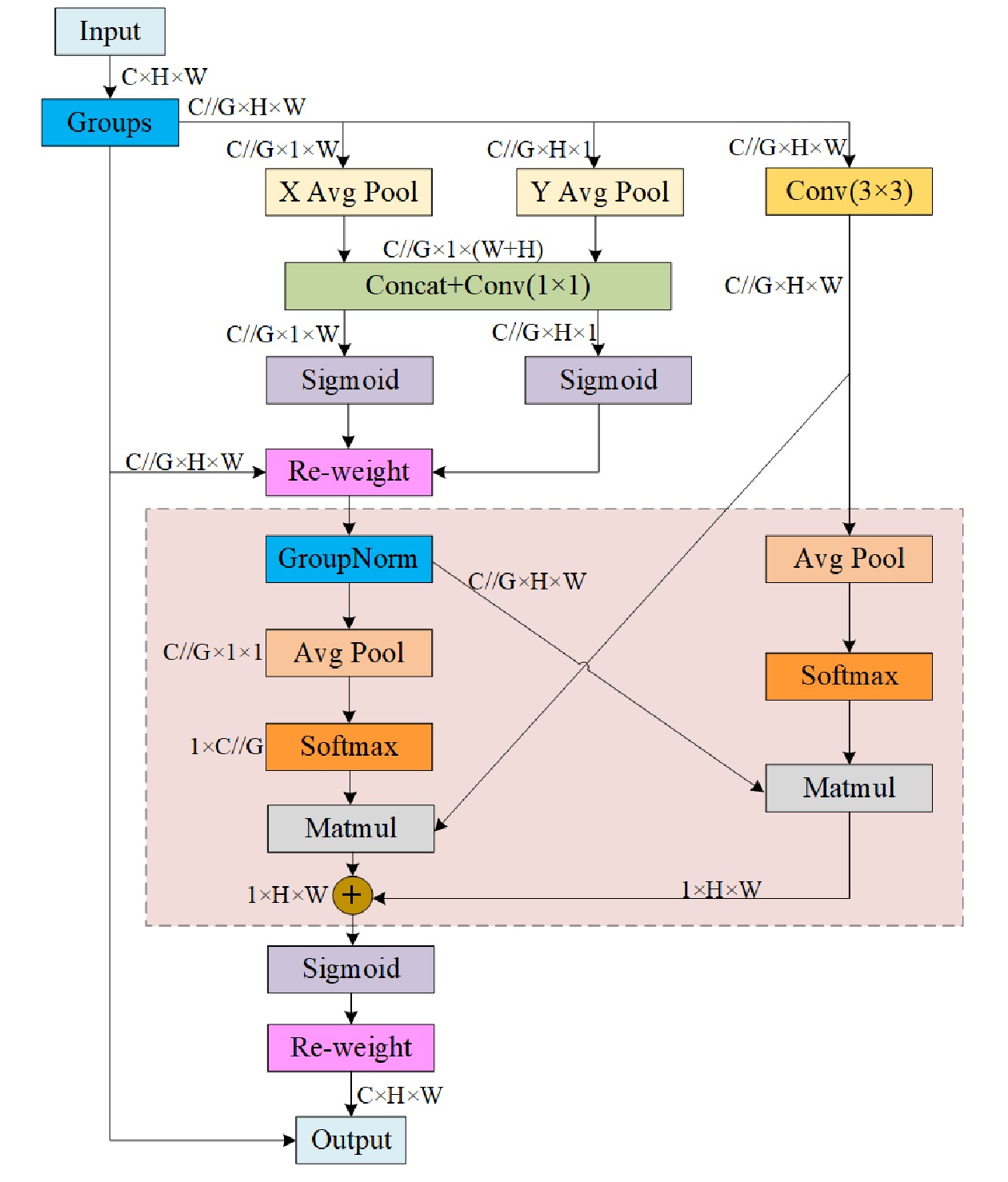

针对影响铁路接触网智能自轮运营维护装备车组(简称:运维车组)作业安全的人员侵入问题,提出了一种基于改进YOLOv8人员检测模型的视觉安全检测方法。以YOLOv8模型为基础,引入FasterNet Block、高效多尺度注意力模块(EMA,Efficient Multi-Scale Attention Module),学习跨空间聚合像素特征;针对单模型漏检,同场景下分别进行头部目标检测和身体实例分割,融合2个识别框,得到精确的识别结果;采用坐标转换法实现人员精准定位,确定人车距离并划分危险等级。该方法实现“识别—定位—预警”全流程,将其应用于智能运维车组中,通过对作业区域人员的检测定位,提升智能运维车组作业安全性。

Abstract:This paper proposed a visual safety detection method based on improved YOLOv8 personnel detection model to address the issue of personnel intrusion that affected the operational safety for intelligent self wheel operation and maintenance equipment vehicle sets (referred to as operation and maintenance vehicle sets) of railway catenary system. Based on the YOLOv8 model and introduced FasterNet Block and Efficient Multi Scale Attention Module (EMA), the paper learned cross spatial aggregated pixel features, focused on single model missed detection and performed head target detection and body instance segmentation separately in the same scene, fusing two recognition boxes to obtain accurate recognition results, and used coordinate transformation method to implement precise personnel positioning, determine the distance between people and vehicles, and classify the danger level. This method implements the entire process of "recognition - positioning - warning" and can be applied to intelligent operation and maintenance vehicle sets. By detecting and locating personnel in the work area, it improves the safety of intelligent operation and maintenance vehicle sets.

-

Keywords:

- YOLOv8 /

- object detection /

- instance segmentation /

- coordinate transformation /

- danger level

-

近年来兴起的列车群组运行控制技术可通过信号技术减少列车间隔[1],为铁路货物运输领域通过加大行车密度解决运能紧张问题提供了新途径。列车运行图是铁路运输工作组织的基础,对列车运行组织和调整起着重要作用,而现有的列车运行图编制系统与具有灵活组群/解群特点的群组列车间适应性较差,不能根据群组运行模式下列车运行状态的动态变化实现精准化编制,无法满足列车群组计划、列车运行计划及运行图协同编制的需求。因此,亟须推进群组运行模式下列车运行图编制理论和技术的创新突破,设计一种高效的群组列车运行图智能化编制系统。

倪少权等人[2-3]提出的计算机编制列车运行图基本规则为后续的计算机编制列车运行图奠定了技术基础;史常庆等人[4]阐述了我国列车运行图编制系统的发展历程,介绍了计算机编制列车运行图取得的重大突破,指出仍需要开发更多功能以实现各相关作业计划的一体化编制;刘庆磊等人[5]基于SQLite数据库、运用Visual Studio 工具,设计开发了基于C/S架构的列车运行图编制系统;张菡[6]指出现有的列车运行图编制系统存在数据准确性、实时性、共享性不足的问题,认为提升计算机性能 是提高计算机编制列车运行图水平的有效途径;李诗雅[7]采用ASP.NET、HTML5和GDI静态图片绘图技术,实现列车运行图的编制。本文结合列车群组运行的特点,在充分借鉴现有运行图编制系统功能的基础上,设计基于群组运行模式的列车运行图编制系统(简称:本文系统)。

1 需求分析

1.1 群组计划与列车运行计划匹配优化需求

群组运行模式下,群组计划与列车运行计划共同构成了编制列车运行图的基础。本文系统需要依据群组计划来制定列车运行计划,列车运行计划的编制结果又会作为反馈,对群组计划进行必要的调整和完善,实现二者的动态匹配。同时,群组计划与列车运行计划的关键要素间存在一定的关联性,需要利用数据共享和交换技术,实现信息的实时流通和同步更新,并运用智能优化算法,实现群组计划和列车运行计划的匹配优化。

1.2 复杂运行环境下群组运行图智能编制需求

基于群组运行的列车运行图编制核心难点在于列车运行环境更加多元且复杂。同时,群组列车的运行线的展示需要区别于传统运行模式,考虑到单元列车的运行间隔大幅缩短,导致运行线在时空维度上呈现出紧密交织状态,运行图的拓扑结构发生较大变化。因此,群组列车运行线的设计需要更加直观简洁。此外,本文系统还需要具备自动铺画和冲突检测功能,能根据群组计划、列车运行计划等基本运输计划,自动绘制合理的列车运行图,并综合考虑车站容量、车站间隔时间等各种约束条件,对运行图进行检查,保障列车运行的平稳和安全。

1.3 不同扰动场景下群组运行图动态调整需求

在群组运行模式下,群组列车运行线之间、群组列车与单元列车运行线间冲突情况更加多样,线间制约关系越发错综复杂。传统方法是通过人机对话手动调整列车运行线,消解不同类型运行线之间的冲突,效率低下且准确率难以保证。然而,在面对诸如组间通信信号故障、组内车载列车自动防护系统(ATP,Automatic Train Protection)单元损坏、极端恶劣天气影响等扰动场景时,需要迅速且准确地选择对应的运输计划及运行图调整策略。因此,本文系统应具备强大的数据分析决策支持能力,实时处理和分析列车运行数据,准确识别扰动场景,自动或辅助调整列车运行图,以确保列车运行的平稳、高效和安全。

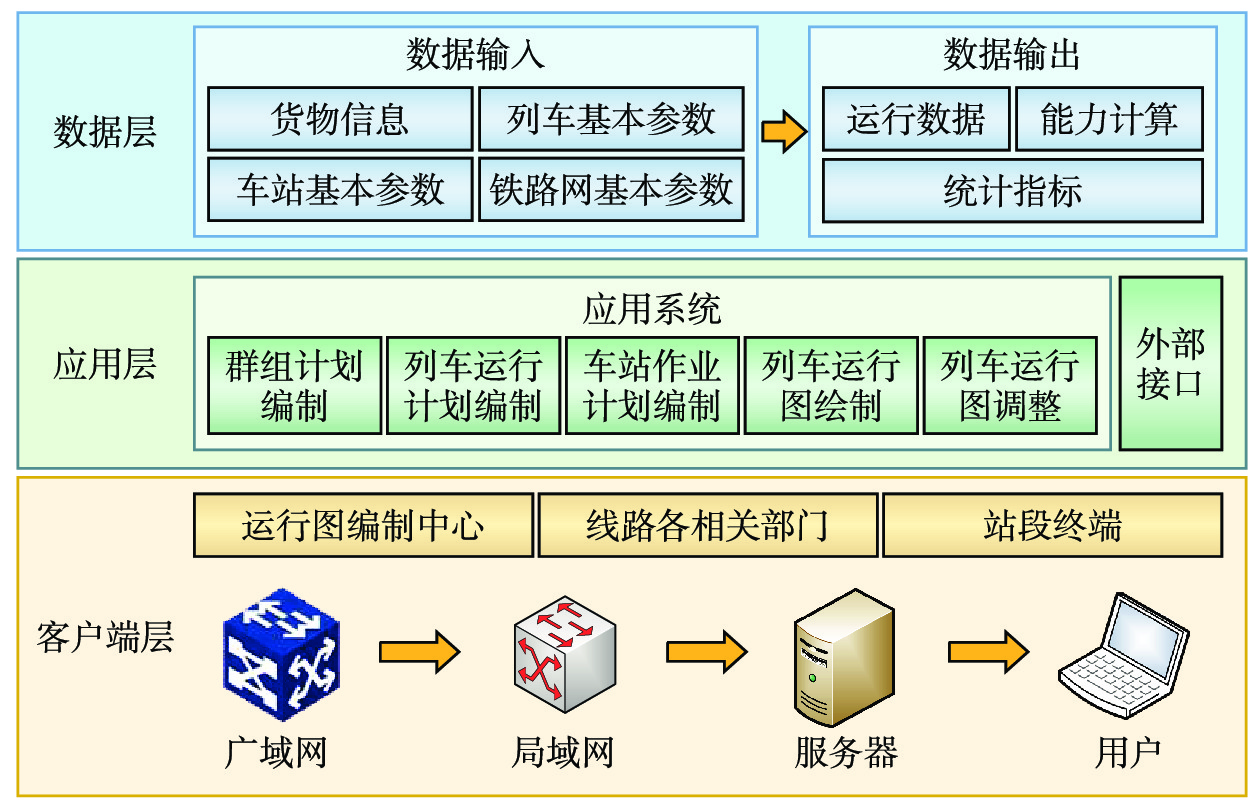

2 系统架构

本文系统采用C/S模式的混合式结构[8]。混合式结构结合了集中式和复制式结构的优点,在保持集中控制的基础上,对传统集中式结构中的服务器进行了“瘦身”,将部分工作转移到客户端,从而提高系统效率,减轻客户端与服务器间的通信负担,本文系统架构如图1所示。

2.1 数据层

数据层负责管理和保存本文系统所需要的所有数据资源,包括货物信息、列车基本参数、车站基本参数和路网基本参数等,这些数据是编制群组计划和列车运行计划的基础,通过各种数据源(如信号系统、人工输入等)对该类数据进行收集,并传输到数据层进行处理和存储。这些基础数据经过应用层计算后,得到的计算结果也存储在数据层中,如群组列车的运行数据、各种能力计算和统计指标等。除此之外,数据层还向应用层提供各项数据服务,包括数据的查询、分析与共享等。

2.2 应用层

应用层是本文系统架构中的核心部分,负责接收来自客户端层的请求,调用数据层的数据资源,执行相应的业务逻辑。根据业务需求和设计标准,应用层包含了群组计划编制、列车运行计划编制、车站作业计划编制、列车运行图绘制与列车运行图调整等主要功能模块,实现自动或辅助编制线网列车运行图及其相关作业计划。

2.3 客户端层

客户端层是与用户终端直接交互的部分,为不同类型用户设置相应的操作权限,并提供直观、友好的交互界面供用户使用。通过输出服务层的处理结果,使不同工况的作业人员能够高效、高质量地进行相关指标的统计与分析。

3 系统功能模块

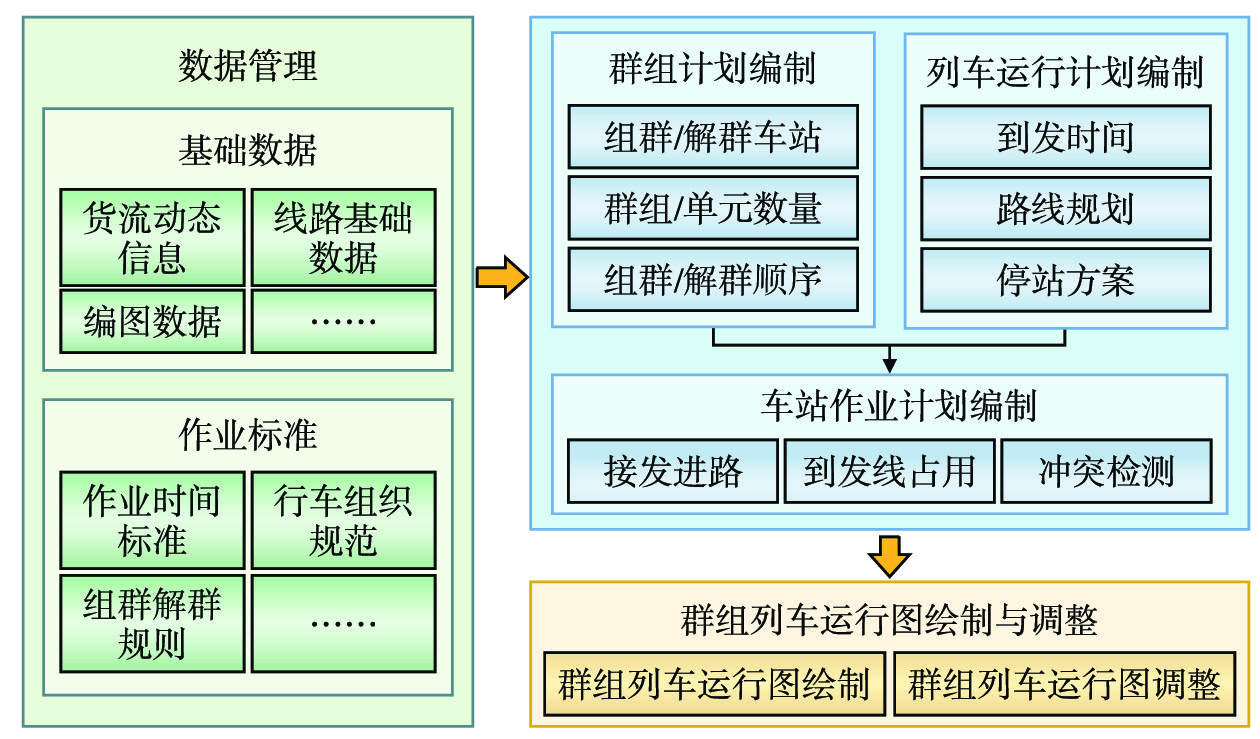

本文系统从数据管理、群组计划编制、列车运行计划编制、车站作业计划编制、群组列车运行图绘制与调整等5个模块进行具体功能设计,其功能架构如图2所示。

3.1 数据管理模块

数据管理模块功能包括高效统筹动态信息、基础数据与编图数据的全生命周期管理,集数据库创建、操作、数据维护于一体,实现数据整合、对比分析及一致性校验等。

3.1.1 基础数据管理

(1)货流动态信息管理:包括确定货物起讫点、运到期限等信息,并实时获取货物运输路径及到达各站点的时间,以满足货物时效性要求。

(2)线路基础数据管理:包括管理车站数据、区间参数、线路类型、闭塞方式等,实现线路基础数据的输入、保存和调用。

(3)编图数据管理:包括管理列车路径、天窗时段及群组列车与单元列车间运行间隔等数据,实现编图数据的输入、保存和调用。

3.1.2 作业标准数据管理

作业标准数据管理将行车组织规范、组群与解群的规则等作业标准转化为结构化数据进行存储和处理,以对计划与运行图编制进行约束,保障编制结果的可行性。

3.2 群组计划编制模块

群组计划是群组运行模式下基本运输计划的基础,决定了对路网整体效能的运用情况。群组计划编制模块功能包括确定组群/解群车站、群组列车开行数量、群组内单元列车开行数量、单元列车组群顺序及单元列车占用车站到发线等。该模块依据线路车站和车流信息统筹规划群组列车组群/解群车站、组群数量、顺序及停靠到发线,展示群组列车在运行线路各区间、车站的运行状态及状态转换情况,辅助用户进行决策。

3.3 列车运行计划编制模块

列车运行计划编制模块功能包括确定到发时间、运行时长、路线规划及停站方案等。该模块通过优化调度模型和算法生成列车运行计划,提升列车运行效率及运力资源利用效率;提供高效的人机交互编制与实时调整功能,利用数据可视化技术展示各线路和区间的运输能力及动态时刻表;进行相关指标的统计与分析,以支持决策制定和系统性能评估。

3.4 车站作业计划编制模块

车站作业计划编制模块功能包括实现群组列车与单元列车的到发作业与接发进路,单元列车等待组群的到发线占用股道及时间,单元列车的装卸作业、车站线路及作业冲突检测等关键流程的一体化编制,并实时检测车站作业进度及计划编制的可行性。同时,该模块提供多样化的编制和调整工具,方便用户进行车站作业计划的图表设计及动态调整。

3.5 运行图绘制与调整模块

(1)运行图绘制功能:包括列车运行时间推算、列车运行线自动铺画、列车运行线冲突检测及相关指标统计等。实现列车运行图的自动绘制,并提供群组运行模式下列车运行路径和运输时刻的可视化展示,以便在后续调整功能中根据路网实时动态货流信息进行列车运行线的调整。

(2)运行图调整功能:包括多源信息融合的列车群组运行态势表征指标体系、列车群组运行冲突检测与预警、群组运行图自动或人机交互调整等。通过解析群组列车运行的多源影响因素(如设施设备、环境、人为等),结合列车群组停运、加开、变更规模、变更到发时刻、变更列车顺序等运力资源调配策略,实现典型干扰场景下群组计划、列车运行计划、车站作业计划等一体化动态运行图调整。

4 关键技术

4.1 数据交互与信息共享技术

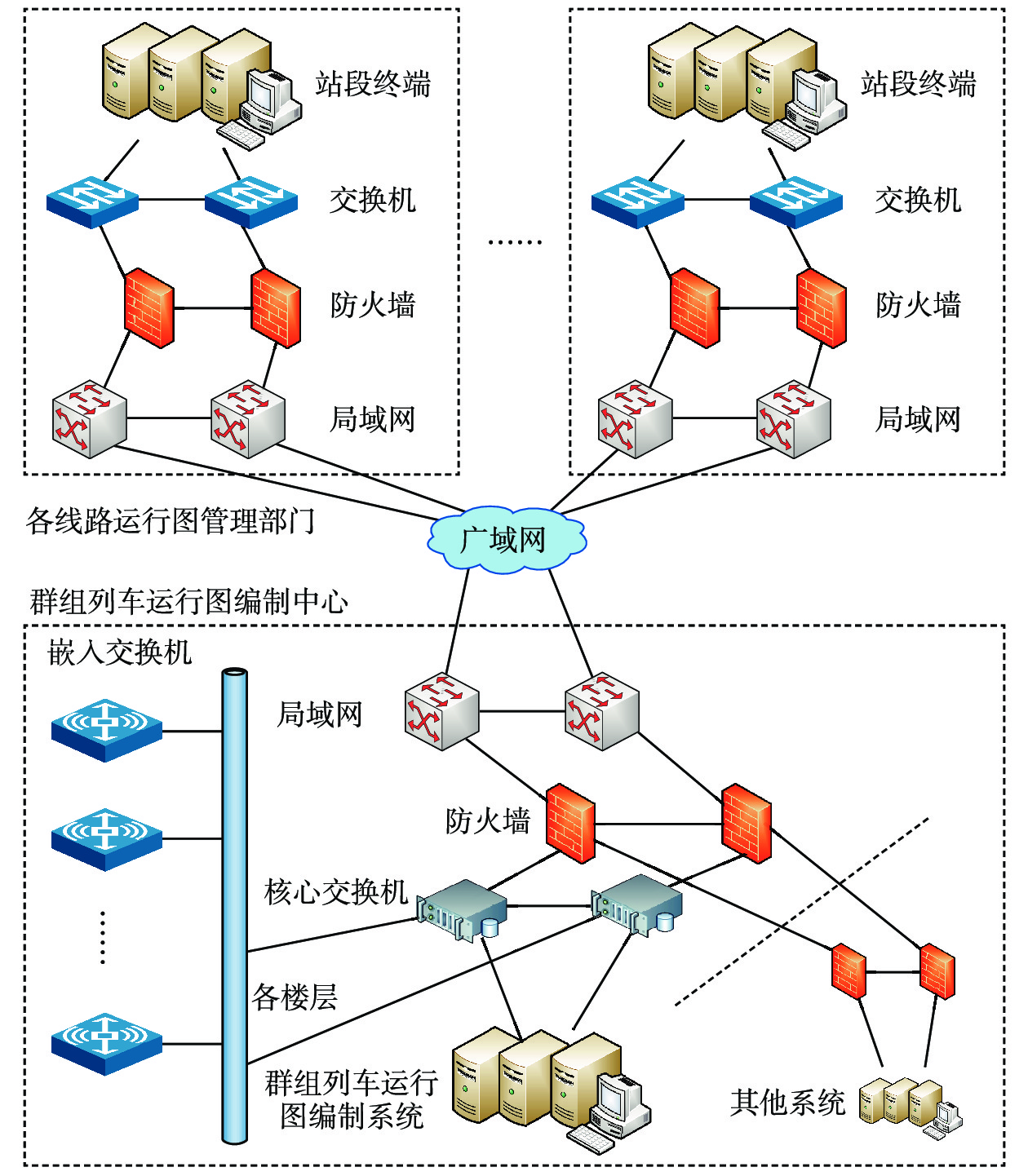

广域网连接多个局域网,常用于在有限区域内连接设备以实现资源共享。本文系统中各项业务间相互影响,从网络体系上分为广域网和局域网:广域网包括群组列车运行图编制中心与各线路相关部门之间的广域网络连接,在保障网络安全的前提下,满足信息共享需求;各线路内部的站段终端组建局域网,保障各项调度工作计划的编制。本文系统支持运用广域网和局域网技术实现不同子系统业务间有效数据的筛选及加密传输/接收等;并在参数运算与规范化整合后定时将归类的数据传输到其他子系统,实现多源异构数据的汇聚整合及信息交互,其网络架构如图3所示。

4.2 可视化展示技术

ZRender框架是基于HTML5 Canvas的开源绘图库,常用于展示统计数据、图表和实时数据监控。本文系统支持运用基于数据驱动的ZRender可视化技术进行基础数据与编图数据的绘制和交互。借助ZRender提供的丰富图形绘制API,定义运行图数据,创建各种图形元素,实现复杂的数据可视化效果。提供列车全生命周期的状态与位置、车站作业的全方位可视化展示,并对运行图进行缩放、拖拽、选取等操作。

4.3 群组列车运行线表示方法

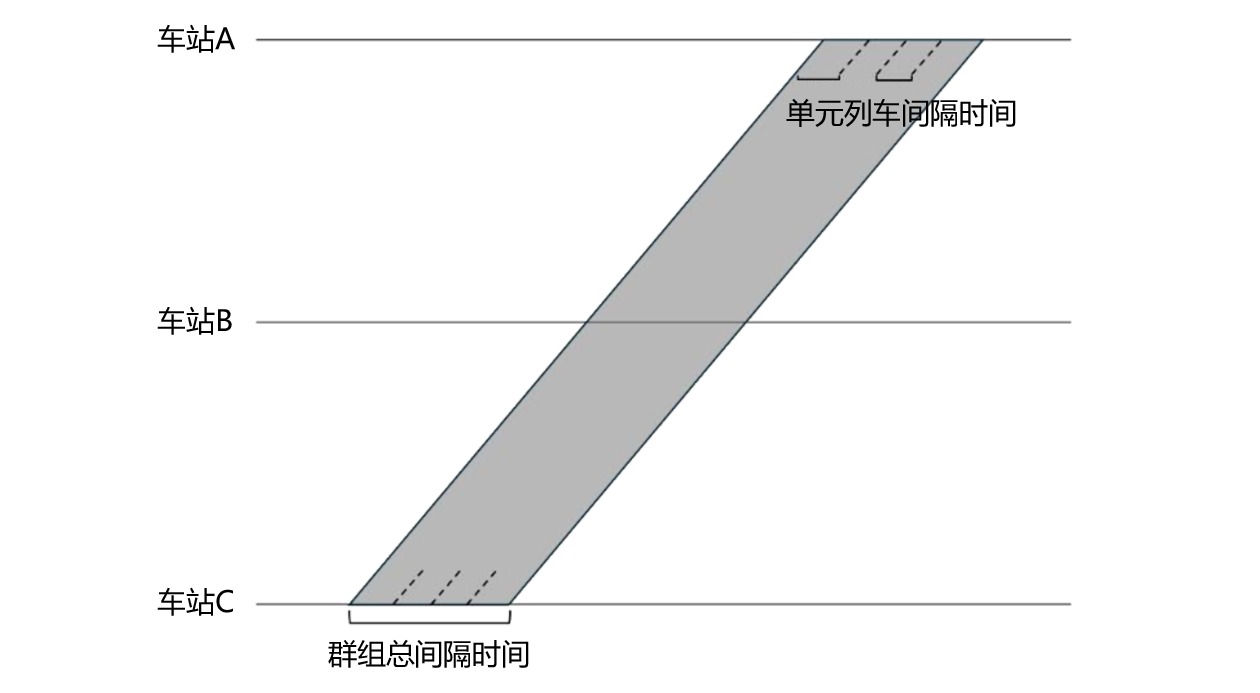

列车运行线是运行图的重要组成元素,通常使用不同颜色的单一直线来表示不同类型的列车。由于群组列车运行期间其追踪间隔较小,常规的列车运行线表示方法难以直观、准确地区分群组列车与单元列车。因此,本文提出群组运行区域的表示方法,展示群组列车与单元列车在区间的占用情况。运用黑色单线表示群组首车,另一黑色单线表示群组尾车,两条单线之间辅以灰色阴影表示群组列车总间隔时间,如图4所示。群组车次定为Q1至Q9999,“Q”读作“群”;群组内单元列车车次依据群组车次分别规定为Q1-1至Q1-10,Q2-1至Q2-10,······,以此类推,依据车次号确定群组规模。

4.4 群组运行图编制技术

4.4.1 分层决策技术

深度强化学习是结合深度学习与强化学习的一种机器学习方法,其核心思想是通过与环境的交互来学习最佳策略,以最大化累积奖励,具有强大的特征提取能力。

本文系统支持运用深度强化学习等技术,将运行图编制问题解耦为仿真环境与智能体,构建深度神经网络作为智能体,从高维的环境状态映射至行动;基于运行图编制的序列决策特性,支持构建通用的马尔科夫决策过程模型,运用单智能体深度强化学习算法实现群组计划、列车运行计划及车站作业计划的智能编制。

4.4.2 车站内群组运行态势智能感知与推演技术

数据分析与挖掘技术能够提取有用数据及数据间的潜在关系。TOPSIS是一种综合评价方法,通过检测评价对象与最优解、最劣解的距离进行排序,得出最优方案。

本文系统支持运用数据分析、信息挖掘等手段提取技术站内群组运行状态的影响因素及关键参数,构建多维度表征指标体系;运用TOPSIS评价方法多层次评估车站内群组运行的态势,并运用图神经网络进行描述,实现时间−事件混合驱动的群组运行态势动态感知与推演,确保群组列车在站内到发线运用及等待组群时间的合理性,最大化车站运力资源的利用效率。

4.4.3 群组运行冲突智能检测与动态调整技术

图神经网络使用神经网络学习、提取和发掘图结构数据特征,常用方法包括图卷积网络、图注意力网络等。

本文系统支持分析群组列车历史运行数据,提取并校验各类别冲突指标,形成冲突智能检测与判定方法。提取不同时刻下列车运行与技术作业状态,运用图神经网络进行时间−事件驱动下的冲突实时预测。分析并量化群组计划、列车运行计划、车站作业计划间的关联关系,运用网络优化、强化学习等方法实现典型冲突与干扰条件下各计划与运行图的动态一体化调整。

5 结束语

本文系统实现了群组计划、列车运行计划、车站作业计划、列车运行图的智能编制,考虑到群组运行模式下列车运行方式及运行图拓扑结构的改变,设计了数据管理、群组计划编制、列车运行计划编制、车站作业计划编制、群组列车运行图编制与调整等功能,引入群组运行线表示方法及ZRender二维图像绘制框架实现群组列车运行线的自动铺画,达到列车运行方案精确可视化的效果。本文系统相较于既有的运行图编制方式,该通过引入数据交互与信息共享、群组运行冲突智能检测与动态调整等技术,弥补了业务协作、反馈调整的准确性与动态性不足的问题;通过深度强化学习等技术,解决群组列车运行图编制分层决策问题,显著提升群组运行图的编制效率。

下一步,计划在重载货运铁路中试用本文系统,以促进列车群组运行控制系统研究成果落地并产生经济效益。

-

表 1 人员图像数据集样本信息

单位:张 种类 初始数据集 增强数据集 训练集 验证集 测试集 总计 矩形框头部集 1982 2676 298 330 3304 多边形身体集 2609 290 322 3221 表 2 目标检测消融试验结果对比

模型 mAP_0.5 mAP_0.5:0.95 FPS/(帧·s-1) YOLOv8 88.2% 56.9% 43.85 YOLOv8+EMA 89.3% 59.2% 41.6 YOLOv8+C2f-Faster 89.0% 58.9% 39.84 YOLOv8+EMA

+C2f-Faster

(本文模型)

89.8%

60.4%

42.5表 3 实例分割消融试验结果对比

模型 mAP_0.5 mAP_0.5:0.95 FPS/(帧·s-1) YOLOv8 91.1% 70.0% 49.51 YOLOv8+EMA 90.9% 69.3% 49.45 YOLOv8+C2f-Faster 91.8% 71.0% 48.27 YOLOv8+EMA

+C2f-Faster

(本文模型)

92.1%

73.3%

47.39表 4 坐标验证结果

编号 转换坐标/m 实际坐标/m 误差/cm 1 (1.83,1.72) (1.85,1.70) (2,-2) 2 (1.51,1.68) (1.55,1.70) (4,2) 3 (2.63,1.69) (2.60,1.70) (-3,1) 4 (2.32,1.68) (2.30,1.70) (-2,2) 5 (2.57,1.02) (2.60,1.00) (3,-2) 6 (2.08,1.03) (2.10,1.00) (2,-3) 7 (2.84,1.03) (2.80,1.00) (-4,-3) 8 (2.58,1.39) (2.60,1.40) (2,1) 9 (2.28,1.36) (2.30,1.40) (2,4) 10 (2.78,1.37) (2.80,1.40) (2,3) -

[1] Faugeras O D, Luong Q T, Maybank S J. Camera self-calibration: theory and experiments[C]//Proceedings of the Second European Conference on Computer Vision, 19–22 May, 1992, Santa Margherita Ligure, Italy. Berlin, Heidelberg: Springer, 1992. 321-334.

[2] 邱晓荣,刘全胜,赵 吉. 基于主动视觉的手眼系统自标定方法[J]. 中国测试,2018,44(7):1-6. DOI: 10.11857/j.issn.1674-5124.2018.07.001 [3] 刘伦宇. 高精度单目视觉定位技术及其在PCBA中的应用研究[D]. 重庆:重庆理工大学,2022. [4] 马 建. 基于机器视觉的工件识别与定位系统的设计与实现[D]. 沈阳:中国科学院大学(中国科学院沈阳计算技术研究所),2020. [5] Zhang Z. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330-1334. DOI: 10.1109/34.888718

[6] 杨鹿情. 基于单目视觉的室内移动机器人定位技术研究[D]. 上海:上海师范大学,2020. [7] Redmon J, Divvala S, Girshick R, et al. You only look once: unified, real-time object detection[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition, 27-30 June, 2016, Las Vegas, NV, USA. New York, USA: IEEE, 2016. 779-788.

[8] Redmon J, Farhadi A. YOLOv3: an incremental improvement[DB/OL]. (2018-04-08)[2024-06-20]. http://arxiv.org/abs/1804.02767.

[9] Redmon J, Farhadi A. YOLO9000: better, faster, stronger[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition, 21-26 July, 2017, Honolulu, HI, USA. New York, USA: IEEE, 2017. 7263-7271.

[10] Bochkovskiy A, Wang C Y, Liao H Y M. Yolov4: Optimal speed and accuracy of object detection[C]// Proceedings of European Conference on Computer Vision (ECCV). Glasgow, UK, 2020, 10934.

[11] Zhu X K, Lyu S C, Wang X, et al. TPH-YOLOv5: improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios[C]//Proceedings of 2021 IEEE/CVF International Conference on Computer Vision Workshops, 11-17 October, 2021, Montreal, BC, Canada. New York, USA: IEEE, 2021. 2778-2788.

[12] ZHENG GE, SONGTAO LIU, FENG WANG, et al. YOLOX: Exceeding YOLO Series in 2021[EB/OL]. (2022-12-23)[2024-06-20]. https://arxiv.org/pdf/2107.08430.pdf.

[13] Wang C Y, Bochkovskiy A, Liao H Y M. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]//Proceedings of 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 17-24 June, 2023, Vancouver, BC, Canada. New York, USA: IEEE, 2023. 7464-7475.

[14] Reis D, Kupec J, Hong J, et al. Real-Time Flying Object Detection with YOLOv8[EB/OL]. (2023-05-17)[2024-06-20]. https://arxiv.org/pdf/2305.09972.pdf.

[15] Chen J R, Kao S H, He H, et al. Run, don't walk: chasing higher FLOPS for faster neural networks[C]//Proceedings of 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 17-24 June, 2023, Vancouver, BC, Canada. New York, USA: IEEE, 2023. 12021-12031.

[16] Ouyang D L, He S, Zhang G Z, et al. Efficient multi-scale attention module with cross-spatial learning[C]//Proceedings of ICASSP 2023-2023 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 04-10 June, 2023, Rhodes Island, Greece. New York, USA: IEEE, 2023. 1-5.

[17] 边 原,赵俊清. 智能识别与空间定位技术在高速铁路车站的应用研究[J]. 铁道运输与经济,2024,46(2):97-104. DOI: 10.16668/j.cnki.issn.1003-1421.2024.02.12.

下载:

下载: