Temperature detection system for key components of metro running gear equipment based on deep learning

-

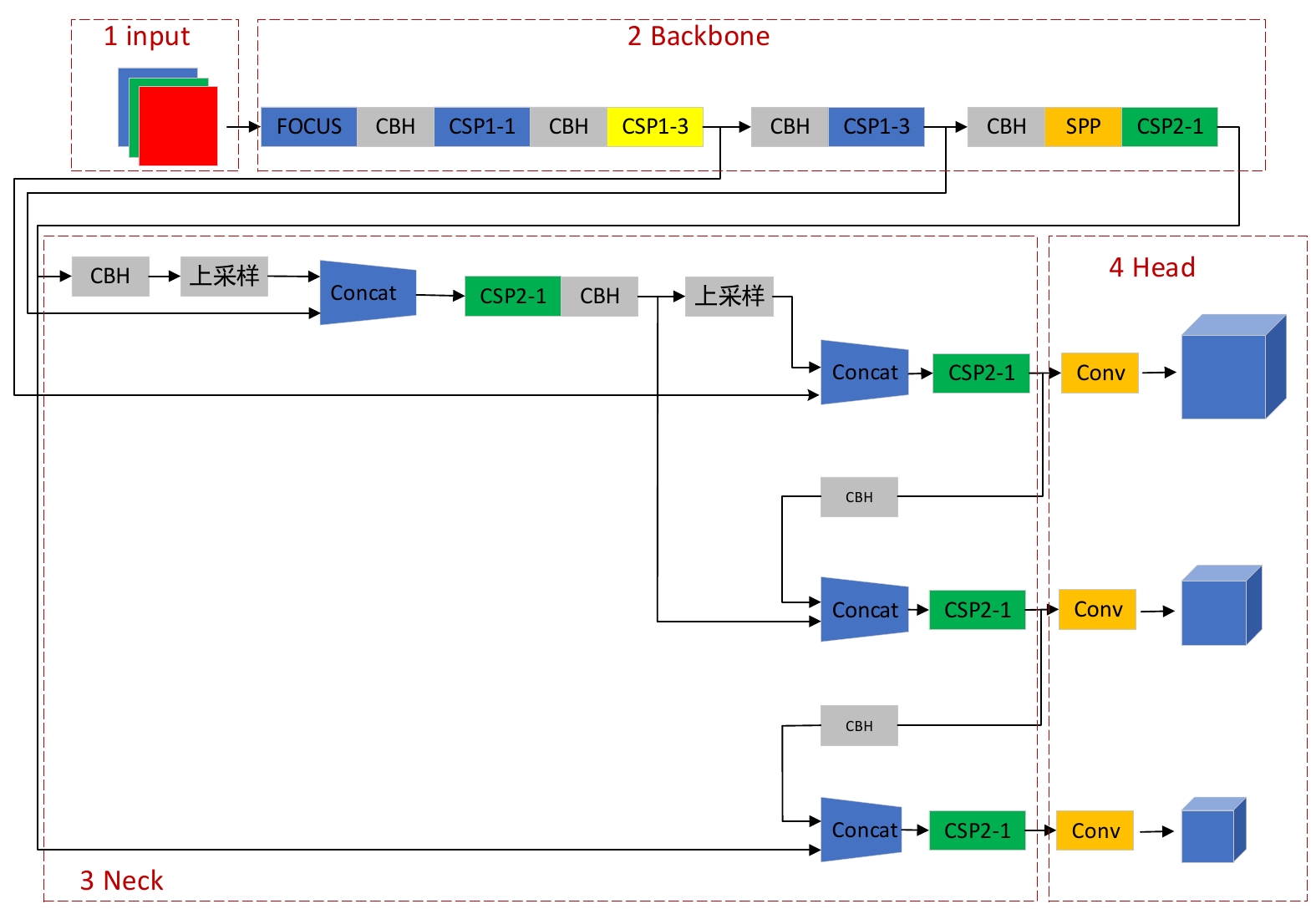

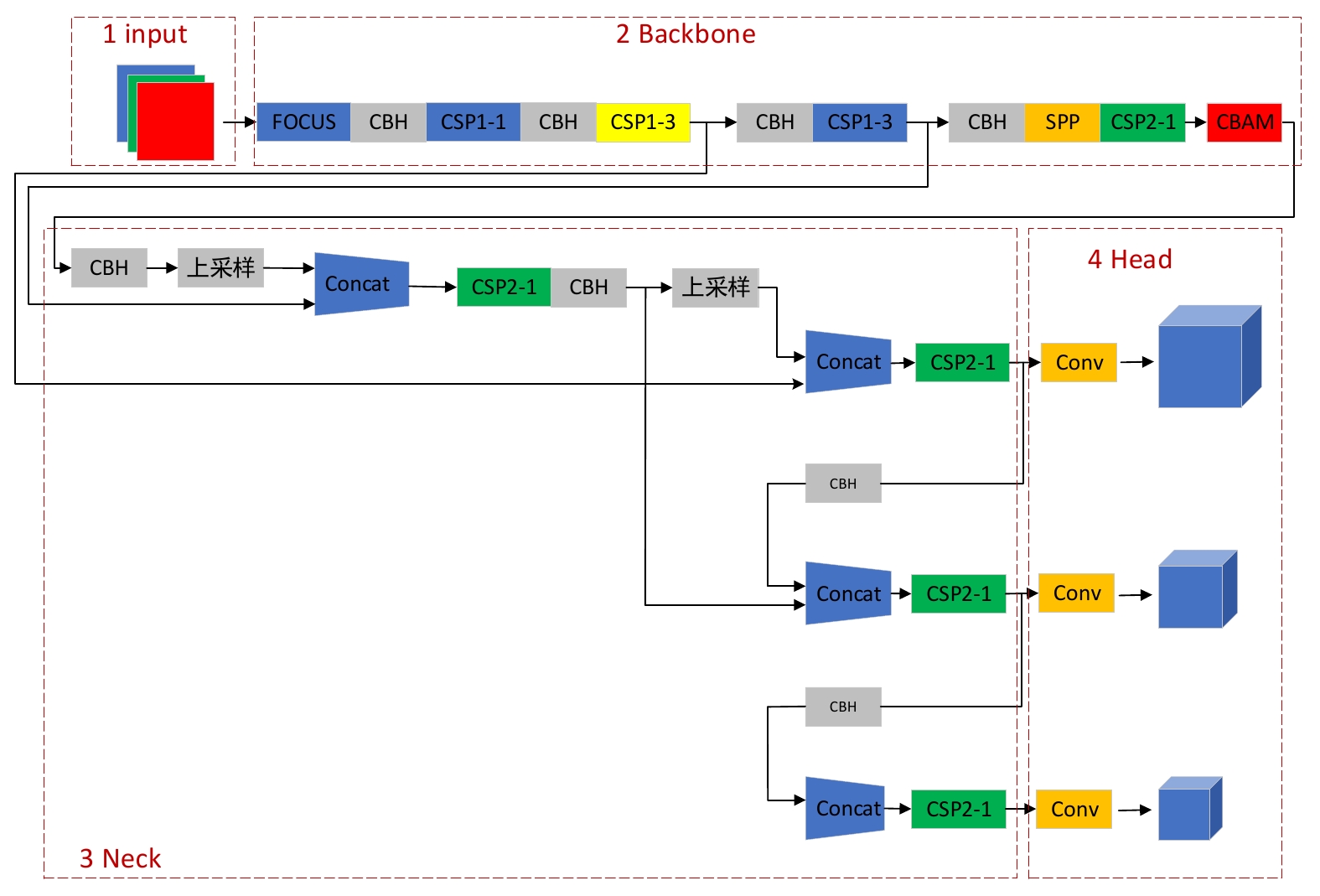

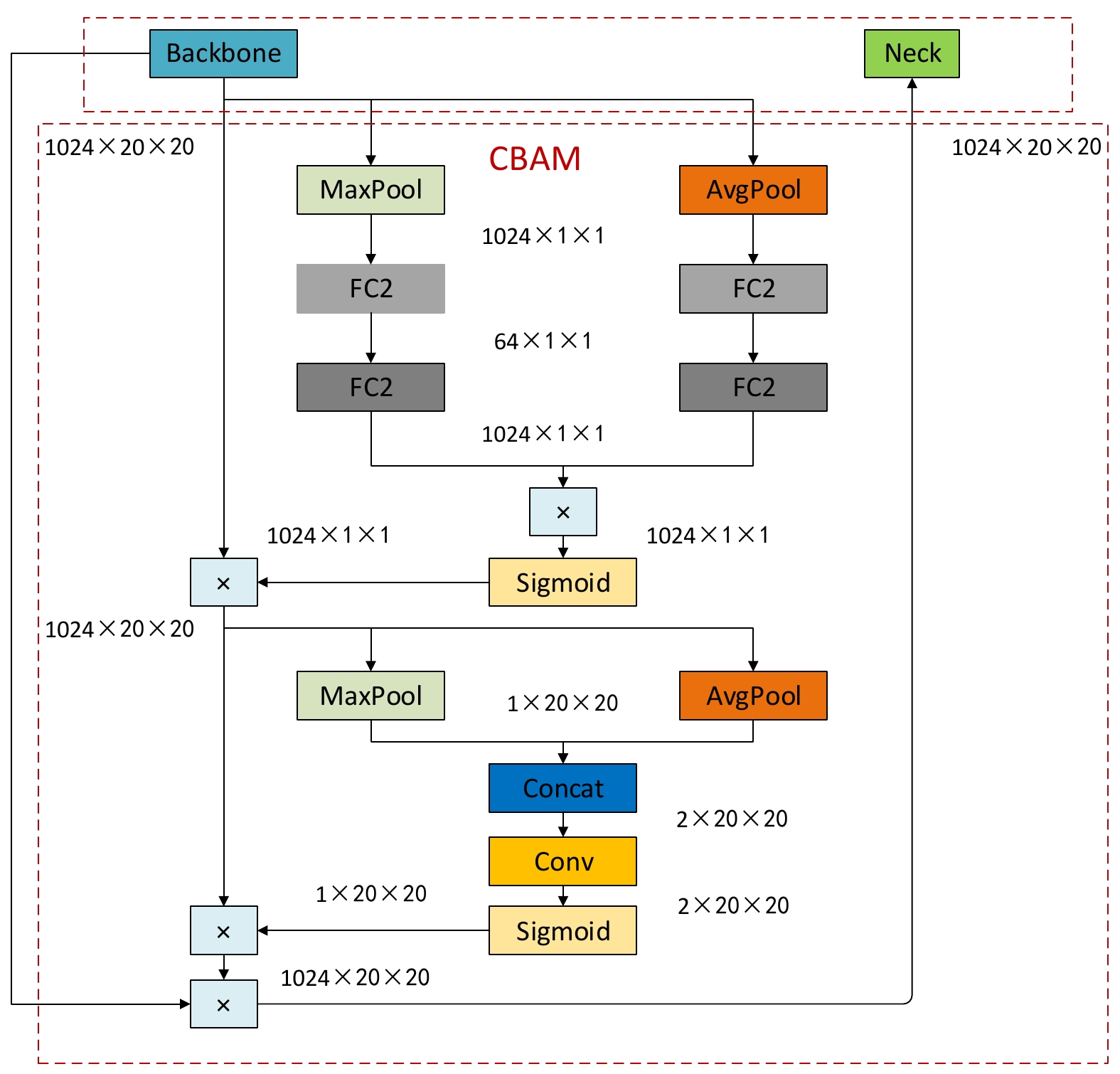

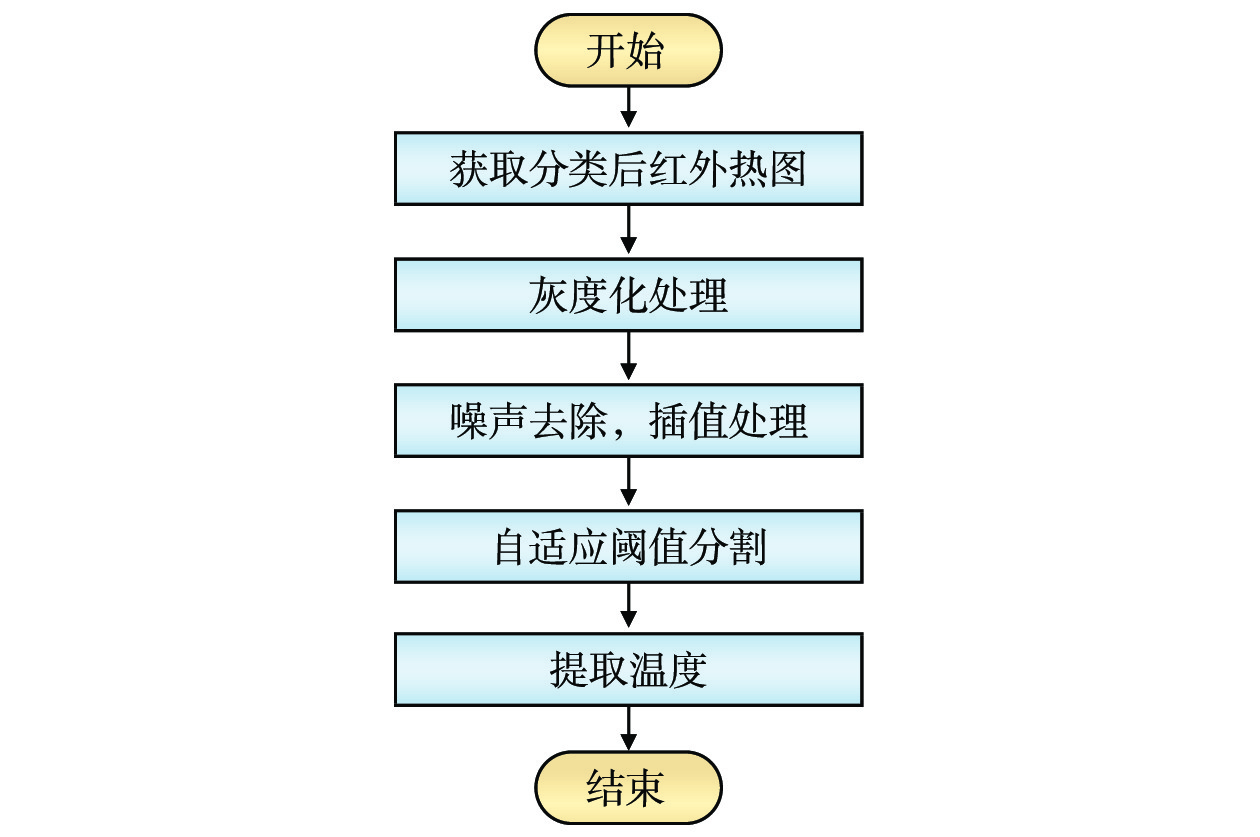

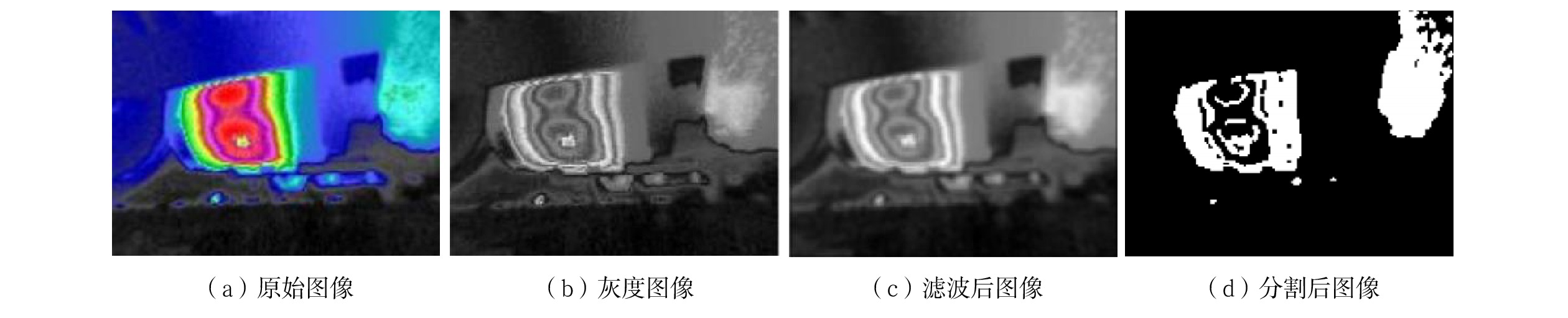

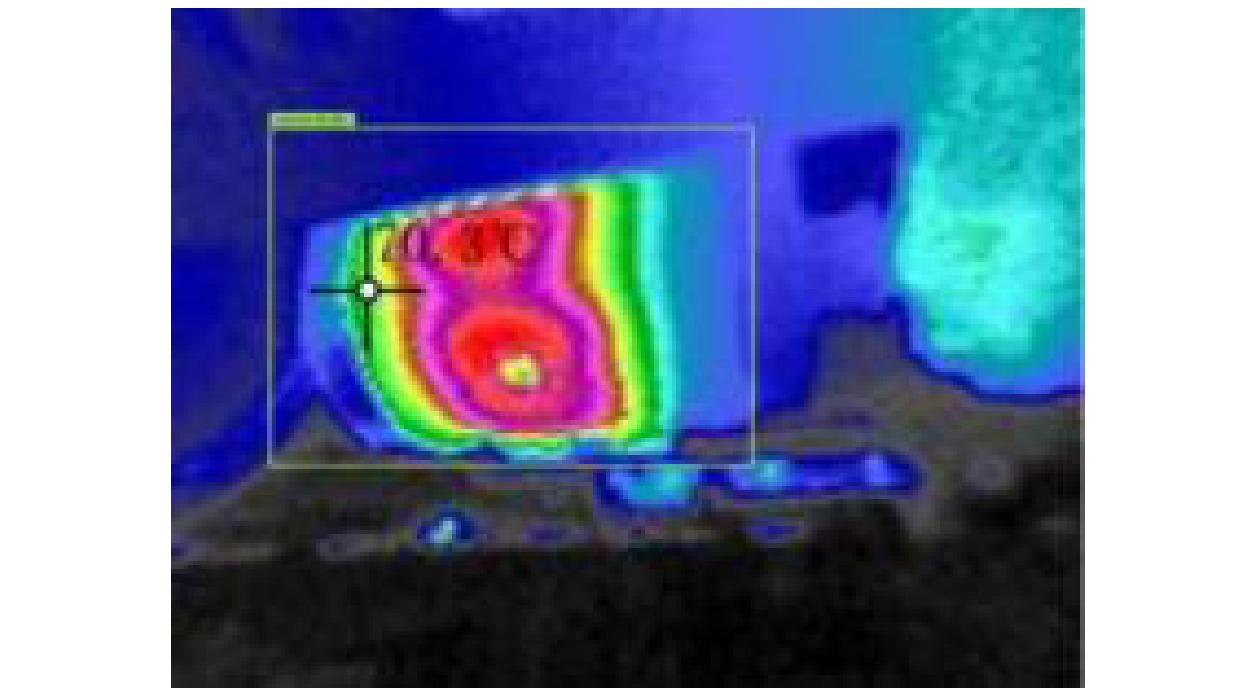

摘要: 地铁列车走行部的良好运行状态是列车安全运行的保障。针对其关键部件发热故障的检测问题,研发了基于深度学习的地铁列车走行部关键部件温度检测系统。该系统采用红外热像仪获取走行部热成像图,引入注意力机制模块和CIoU损失函数,改进YOLOv5目标检测模型,识别、定位出关键部件;对关键部件图像进行灰度化处理和自适应阈值分割等操作,提取温度。基于实验室的Pytorch深度学习平台,在南京地铁运营公司马群车辆段对所研发的系统进行实验。实验结果表明,该系统可以获取走行部热成像图,准确定位关键部件并提取其温度信息。Abstract: The good operation status of the running gear of metro trains is a guarantee of safe train operation. In order to detect the heating faults of key components, this paper developed a temperature detection system for key components of metro running gear equipment based on deep learning. The system used an infrared thermal imager to obtain the thermal image of the running gear, introduced the attention mechanism module and CIoU Loss function, improved the YOLOv5 target detection model, and identifies and locates the key components, performed grayscale processing and adaptive threshold segmentation on key component images to extract temperature. Based on the laboratory's Pytorch deep learning platform, the system developed was tested in Maqun Depot of Nanjing Metro Operation Company. The experimental results show that the system can obtain thermal imaging images of the running gear, accurately locate key components, and extract their temperature information.

-

Keywords:

- metro train /

- running gear /

- infrared thermogram /

- target recognition /

- temperature extraction.

-

铁路工程是我国交通体系的重要组成部分,而铁路电力系统是保证铁路交通正常运行的基础。在铁路工程建设期间,存在供电、用电管理的问题[1],同时,铁路施工用电具有临时性、用电负荷曲线呈驼峰状、用电负荷分布不均匀的特点[2-4],因此,亟需建立一个可智能化管理并实时展示数据的信息化平台[5],以智能化技术进行施工供/用电的计量监控,为施工供/用电管理的决策提供支持[6]。

智能化的电力管理是铁路实现信息化的关键,也是提高工作效率、强化安全卡控的管理手段。目前,铁路工程项目在供/用电管理方面鲜有精细化、智能化的研究成果[7],因此,本文根据对铁路工程建设过程中施工供/用电管理需求的分析,构建了可采集、存储并自动分析施工供/用电各环节数据的铁路施工电力智能管理系统,从而实现电量电费的自动统计分析及电力数据的可视化展示。

1 需求分析

1.1 业务需求

铁路施工电力智能管理系统业务需求包括以下4个方面:

(1)自动获取并分析智能电表的数据,将建设单位各项目、各标段的电量使用数据全部纳入监管,实现用电量的自动汇总及电费的自动计算;

(2)通过自动获取变电站及开关站自动化设备状态数据,实现对供电量的智能分析,为建设单位费用结算与成本核算提供自动化汇总工具;

(3)将重要工点的用电量与工艺工法结合分析,实现对工点用电量合理性的有效评估;

(4)通过对供/用电数据的实时监控,提升铁路电力供应稳定性,进一步提升供/用电效率。

1.2 安全需求

施工供电的安全需求包括供电线路安全保障和送变电设备安全保障2部分。

(1)供电线路安全保障:自动采集线路供电量数据,通过数据反馈实现远端监测;设立供电量阈值及超限报警机制,当供电量超出正常范围可自行报警,通过系统提示和异常状态提示灯立即通知至相关责任人员尽快抢修,避免用电安全事故发生。

(2)送变电设备安全保障:自动采集送变电关键设备的运行状况数据并传输至管控平台云端,通过系统进行运行状态感知和阈值超限判断,实现异常情况监测,并通过系统提示和异常状态显示形成安全预警。

2 系统设计

2.1 总体架构

根据施工电力工程的建设、监理及施工单位的需求,铁路施工电力智能管理系统总体架构自下而上分为感知层、网络层、数据层、应用层和展示层,如图1所示。

(1)感知层

感知层通过各类前端感知设备采集施工现场数据。前端感知设备包括工程建设、设备监测和视频监控过程中使用的各类相关设备。

(2)网络层

网络层即通过物联网、有线网及无线网等方式,将从感知层获取的数据智能传输至数据层,实现检测数据的上传功能。

(3)数据层

数据层用于数据存储及管理施工阶段智能电表的各类数据,以形成类型全面、格式统一的数据库。该层数据主要包括:①智能电表数据,包含变电站智能电表数量、电量等数据;②项目信息数据,包含各施工标段的工点、构筑物等信息及施工用电的地理位置数据;③项目组织机构及人员数据,包含建设单位、施工单位、标段、部门、工区等机构及其人员的基本数据;④变电站数据,包含现场变电站电压、电流、功率、频率、变压器油温等数据;⑤视频监控数据,包含现场开关站、变电站的视频监控数据等。

(4)应用层

应用层基于感知层和网络层而构建,负责为工程建设信息化的业务应用提供服务,实现信息机房各专业相关数据的统一管理。

(5)展示层

展示层主要通过PC端、移动端、液晶大屏等多种展示途径,提供信息机房各专业设备全方位的数据展示、查询等服务。

2.2 功能设计

铁路施工电力智能管理系统可实现对施工供/用电及其数据的统一管理及展示,其功能架构如图2所示。

2.2.1 供电管理

该模块通过智能电表采集并上传数据,对电表数据进行自动分析及汇总,实现统一管理。

(1)运行状态:统计变电站数量、报警数、正常运行数量;显示各变电站或开关站运行状态数据,包括开关状态、电量、电压等。

(2)供电网络:以卫星地图的形式显示各供电站的分布、供电线路走向及范围、供电线路长度,同时展示工点与智能电表分布情况、汇总智能电表数量及电量。

(3)视频监控:显示各配电站及开关站视频监控实时画面。

(4)供电分析:按时间段汇总各配电站及开关站的供电量及供电量走势曲线,同时统计总供电量、报警数量及安全运行天数等关键监控指标。

2.2.2 用电管理

该模块用于呈现各标段的用电网络结构,并实时统计、显示现场各电表的实时用电量,便于管理人员快速掌握现场用电情况及网络负荷情况,解决抄表难题。

2.2.3 基础数据管理

该模块用于对开关站、智能电表和工点的基本信息进行维护,通过接入多协议、多厂家的智能电表采集并上传数据,对数据进行统一管理。

2.2.4 首页展示功能

按月汇总各个变电站供电量,按月、年汇总智能电表数量、电量及预估费用,并对用户权限内所有智能电表用电量及费用曲线、变电站供电曲线进行展示。

2.2.5 大屏指挥

大屏指挥以组态图形式展示供电网络,并显示智能电表实时电量及状态;通过卫星地图展示供电线路走向、工点与智能电表的分布情况。

3 关键技术

3.1 施工供/用电监测技术

本文通过梳理铁路施工供电线路关键节点,对不同智能电表的数据采集和数据传输能力进行评估分析,采用适合铁路施工供电线路的智能电表,接入供电脉络的各关键点进行持续性监测。在对施工供/用电设备用电情况进行分布式智能监测过程中,遵循“电源—电网—负荷”的三层级节点智能监测模式,配合基于数字化脉络图和供电调度中心联动分析的三层级协同优化调度、评估及电能质量管理方法,对铁路施工供/用电进行实时监测。

数字化脉络图从电源、电网及负荷三层级节点获取供/用电监测数据,数据经分析处理后可反映当前输电线路的稳定性及系统振荡情况。结合供电调度中心反馈的输电系统输电能力和电能质量情况进行状态评估,并据此设置合适的供电控制目标和供电策略,从而建立供电协同优化调度方案,通过供电调度中心实现协同优化调度作业。

3.2 施工用电量智能分析与生产评估技术

本文针对不同标段、工区、工点及工序,建立了以智能电表为核心、多种传感器和监控模块集成的智能感知终端。该终端配置在施工用电设备上,形成多设备集成的监控物联网,从而实现以下功能。

(1)通过智能感知终端采集各施工用电设备的用电量数据,结合施工区段、工序或工法进行设备用电量的纵向对比,并针对不同设备进行用电量的横向对比,实现对施工用电的精细化监测和计量;

(2)通过对不同施工环境下的设备用电量及功率的监测,分析施工环境对设备用电量的影响;

(3)通过对功率异常的设备进行异常原因分析,形成功率异常问题库及解决方案,为后续工程的开展提供帮助。

将施工设备用电量与施工实际进展关联,总结用电量与施工生产环节的关系,并基于此建立工程量与对应用电量的“双量”评价体系,可对电能的有效利用率进行评估。

3.3 施工供电安全保障技术

针对铁路施工供电的安全需求,从供电线安全监测和送变电设备运行状态监测2个方面建立了安全保障体系。

(1)利用智能感知终端,对供电线路进行节点式安全实时监测;采集的数据经网络传输至管控平台,通过提前预设的异常状况预警和报警方式,在管控平台上实现数据分析及异常数据报警。

(2)通过物联网技术自动采集送变电设备运行状况;利用频谱分析和集成化图形展示技术,对送变电设备运行状态进行远程感知;通过设置状态异常阈值及超限判断方法并建立超限报警和风险提示机制,实现对异常情况的监测及安全预警功能。

4 系统实现

4.1 电量电费自动统计分析

(1)按时间段汇总各变电站及开关站的供电量、电表数量等,并以走势曲线图进行展示,同时可显示报警数量及安全运行天数等关键监控指标,如图3所示。

(2)按时间段统计各站点用电费用,并对电费排名进行展示,如图4所示。

(3)首页展示,按月汇总各个变电站供电量,按月、年汇总智能电表数量、电量及预估费用,如图5所示。

4.2 可视化展示

通过地理信息系统(GIS,Geographic Information System)技术,以卫星地图及组态图形式实现了供/用电情况的可视化展示,包括各供电站的分布、供电线路走向、各标段的用电网络结构等。同时,系统还实现了与调度指挥系统的集成,通过调度指挥系统大屏可查看智能供电网络的GIS展示、供电主接线拓扑图及智能电表的数据和分析等界面。

5 结束语

本文结合铁路沿线施工供/用电需求,研发了铁路施工电力智能管理系统。该系统采用智能化的硬件设备及相关技术进行施工供/用电的计量监控,结合工程建设信息化,建立了可实时展示数据的信息化平台。

铁路施工电力智能管理系统已应用于在建铁路,应用效果较好,实现了对施工供/用电的数据采集、实时汇总、自动分析及动态展示的全阶段管理。铁路人员可结合系统综合展示情况,快速掌握施工现场供/用电及网络负荷情况,为电力管理决策提供了支持,并保障了施工用电的安全。该系统对解决铁路沿线施工供电的信息化、数字化、智能化难题具有一定的借鉴意义。

-

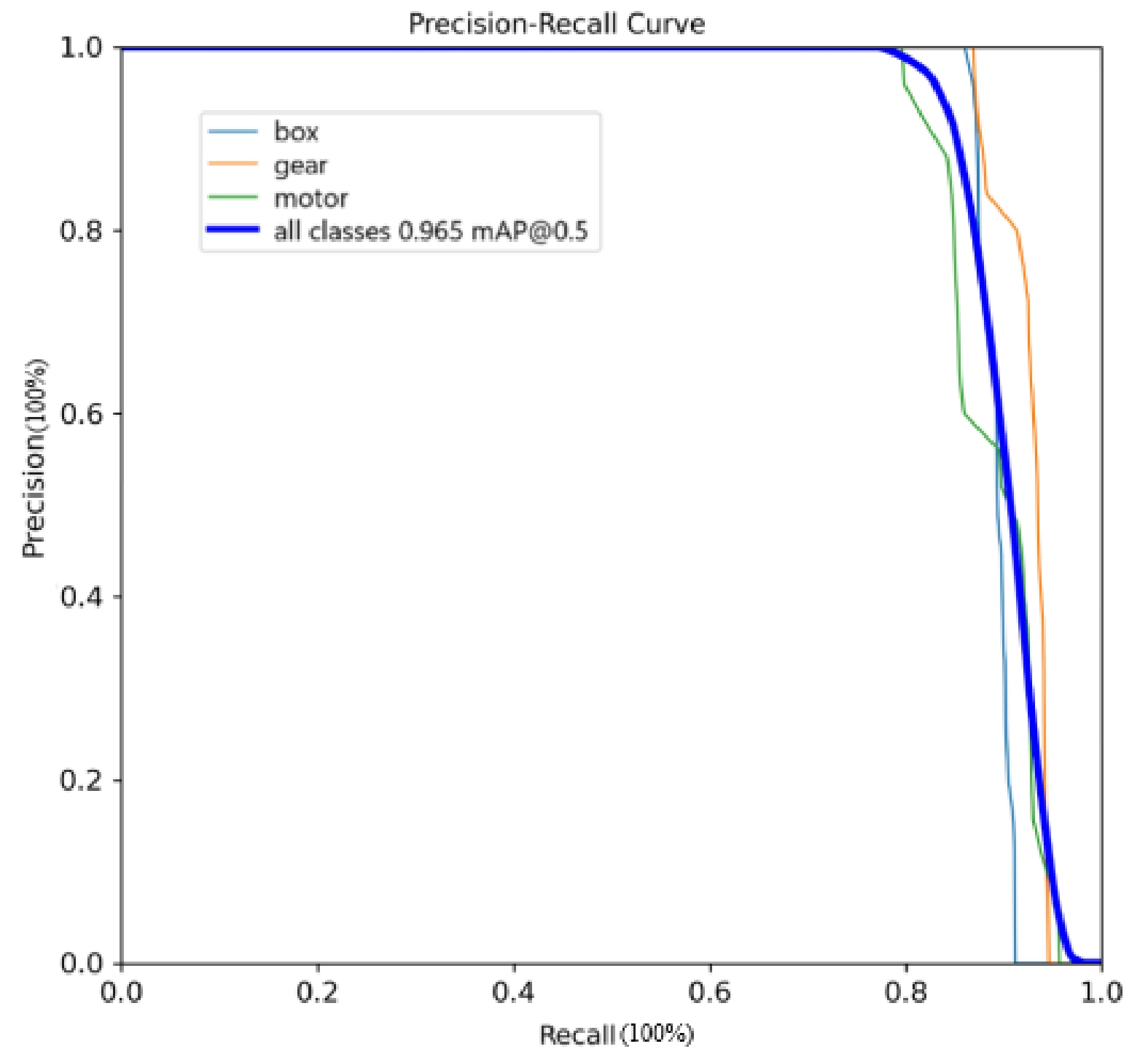

表 1 改进前模型检测精度

精度(Precision) 招回率(Recall) 平均精度(AP) 轴箱 0.951 0.962 0.952 牵引电机 0.949 0.950 0.953 齿轮箱 0.933 0.943 0.951 表 2 改进后模型检测精度

精度(Precision) 招回率(Recall) 平均精度(AP) 轴箱 0.963 0.960 0.971 牵引电机 0.958 0.961 0.970 齿轮箱 0.969 0.954 0.954 表 3 模型改进前、后的训练结果对比

模型 帧速率/FPS 平均精度均值(mAP) mAP@0.5:0.95 YOLOv5s 61.0 0.952 0.840 Improved YOLOv5s 64.5 0.965 0.857 -

[1] 吴庆波. 城市轨道交通技术装备发展现状及发展趋势分析 [J]. 现代城市轨道交通,2020(9):26-29. [2] 吕晓俊,柳 宁,张 业. 速度120 km/h标准地铁列车气动阻力优化研究 [J]. 智慧轨道交通,2023,60(1):24-28. DOI: 10.3969/j.issn.2097-0366.2023.01.006 [3] 董 威,王云飞,张晓宁,等. 高速列车走行部监测系统全冗余技术方案研究 [J]. 控制与信息技术,2020(6):77-82. [4] 马庆杰,程 佳,王国庆. 城轨车载走行部故障检测系统研究与设计 [J]. 中国设备工程,2022(14):82-84. DOI: 10.3969/j.issn.1671-0711.2022.14.036 [5] 史晓磊,蒋 荟. 车辆运行品质安全监测系统报警车辆联网监控的研究及实现 [J]. 铁路计算机应用,2019,28(5):11-14. DOI: 10.3969/j.issn.1005-8451.2019.05.003 [6] 邬春晖,夏志成,高一凡,等. 城轨列车走行部地面检测系统研究与设计 [J]. 都市快轨交通,2021,34(4):69-74. DOI: 10.3969/j.issn.1672-6073.2021.04.011 [7] 潘娟娟. 基于红外测温的地铁列车轴温在线监测系统[D]. 南京: 南京理工大学, 2017. [8] 谢千野. 基于ZigBee的地铁列车轴温检测设计与实现[D]. 成都: 西南交通大学, 2017. [9] 刘志宏. 某型地铁列车轴温预测研究[D]. 兰州: 兰州交通大学, 2021. [10] 张冠男. 地铁车辆走行部温度目标可视化监测方法 [J]. 交通科技与管理,2021(29):4-5. [11] Zhou F R, Ma Y, Ma Y T, et al. Infrared image fault identification method based on YOLO target detection algorithm[M]. Barolli L, Amato F, Moscato, et al. Web, Artificial Intelligence and Network Applications. Cham: Springer, 2020: 461-470.

[12] 杨 尧. 基于计算机视觉的地铁列车关键部件缺陷检测算法研究[D]. 成都: 西南交通大学, 2021. [13] Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition, 23-28 June, 2014, Columbus, OH, USA. New York, USA: IEEE, 2014: 580-587.

[14] Girshick R. Fast R-CNN[C]//Proceedings of 2015 IEEE International Conference on Computer Vision, 7-13, December 2015, Santiago, Chile. New York, USA: IEEE, 2015: 1440-1448.

[15] Redmon J, Divvala S, Girshick R, et al. You only look once: unified, real-time object detection[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 27-30 June, 2016, Las Vegas, NV, USA. New York, USA: IEEE, 2016: 779-788.

-

期刊类型引用(1)

1. 余晓丹,王国梁,王孟丽. 基于物联网的远程医疗监控系统设计与实现研究. 中国宽带. 2025(02): 142-144 .  百度学术

百度学术

其他类型引用(1)

下载:

下载: